How to - benutzerdefinierte Modelle

Verwende benutzerdefinierte Modelle oder lokale Modelle in mium.chat (Vicuna, Alpaca, LLaMa, GPT4All, Dolly, etc.)

Übersicht

mium.chat ermöglicht es dir, die App mit jedem beliebigen Sprach-Modell zu verbinden.

Bedingungen:

- Das Modell muss über einen OpenAI-kompatiblen API-Endpunkt bereitgestellt werden.

- Du musst über entsprechende technische Kenntnisse verfügen, um ein benutzerdefiniertes Modell auf deinem eigenen Server/Endpunkt einzurichten.

Im Folgenden findest du eine kurze Anleitung, wie du mium.chat mit einer beliebten lokalen KI einrichtest, die das Open-Source-Projekt LocalAI nutzt.

LocalAI auf deinem Gerät einrichten

Gehe auf https://github.com/go-skynet/LocalAI und folge den Anweisungen, um ein Modell auf deinem Gerät auszuführen.

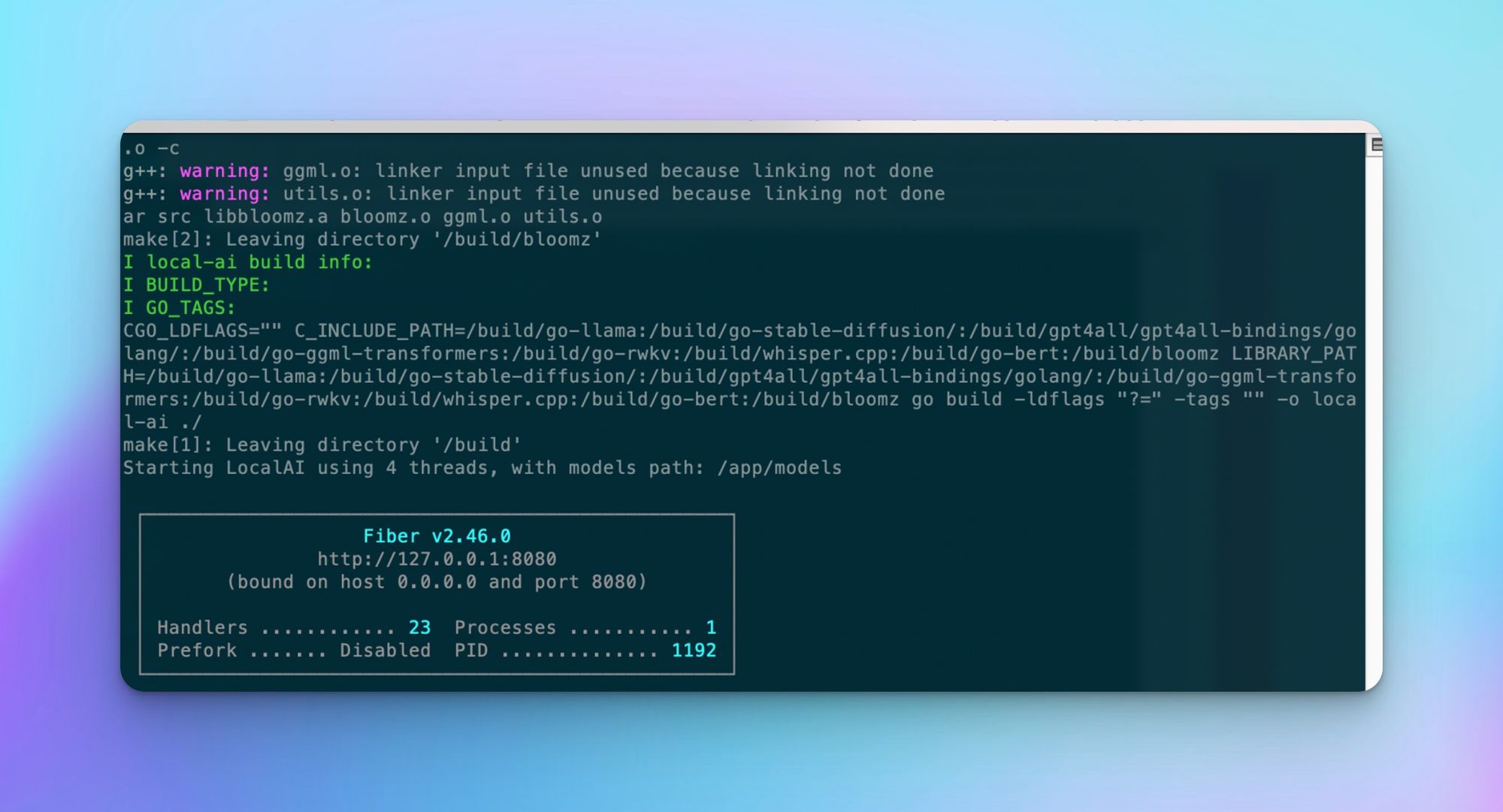

Hier ist zum Beispiel der Befehl, um LocalAI mit Docker einzurichten:

docker run -p 8080:8080 -ti --rm -v /Users/matthias/Desktop/models:/app/models quay.io/go-skynet/local-ai:latest --models-path /app/models --context-size 700 --threads 4 --cors trueHinweis: Aktualisiere den Pfad "/Users/matthias/Desktop/models", damit er mit deiner Geräteeinstellung übereinstimmt.

Wenn du es richtig machst, solltest du eine Meldung wie diese sehen:

Jetzt kannst du auf http://localhost:8080/v1/models gehen und bestätigen, dass das Modell fertig ist:

Benutzerdefiniertes Modell für mium.chat einrichten

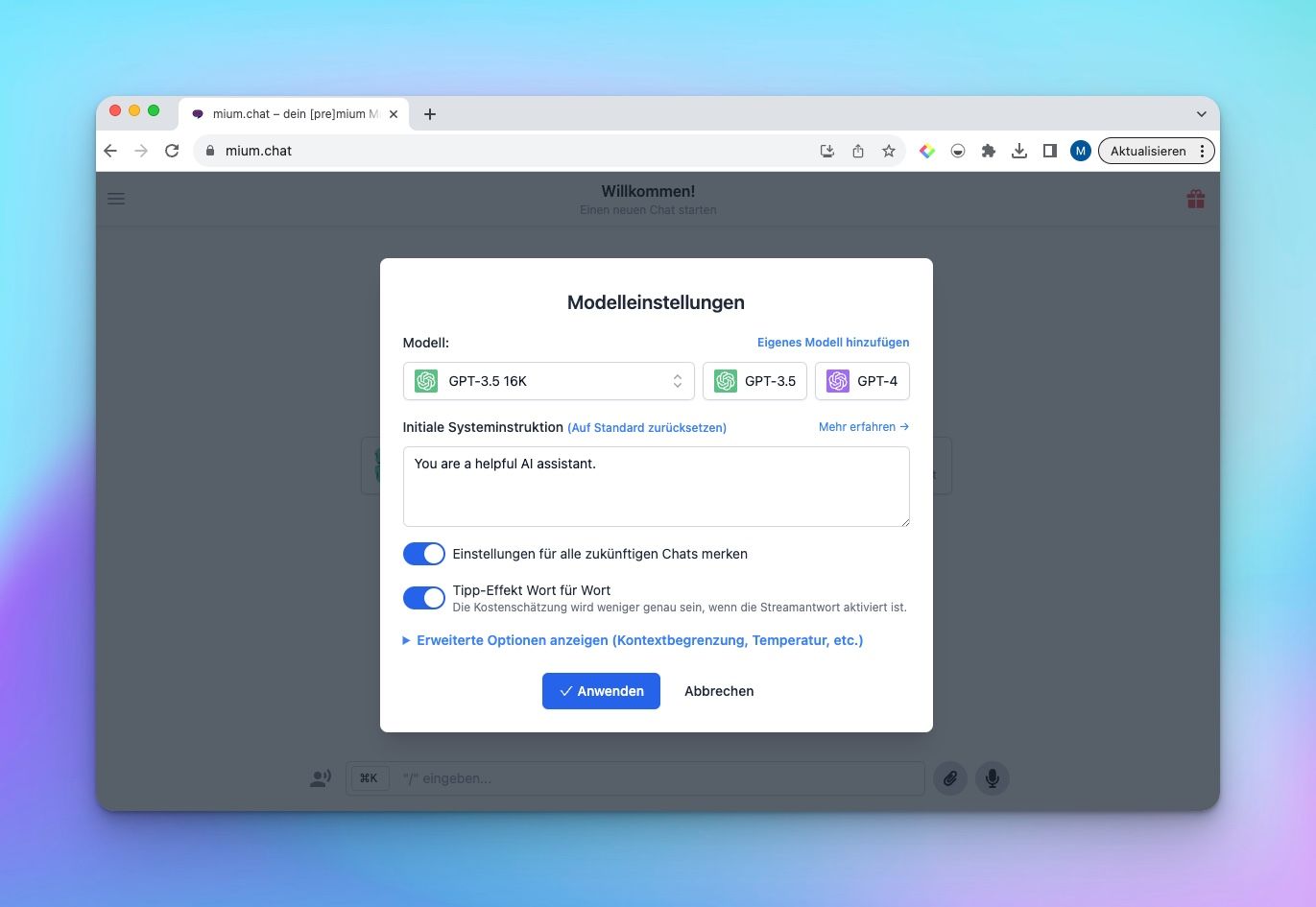

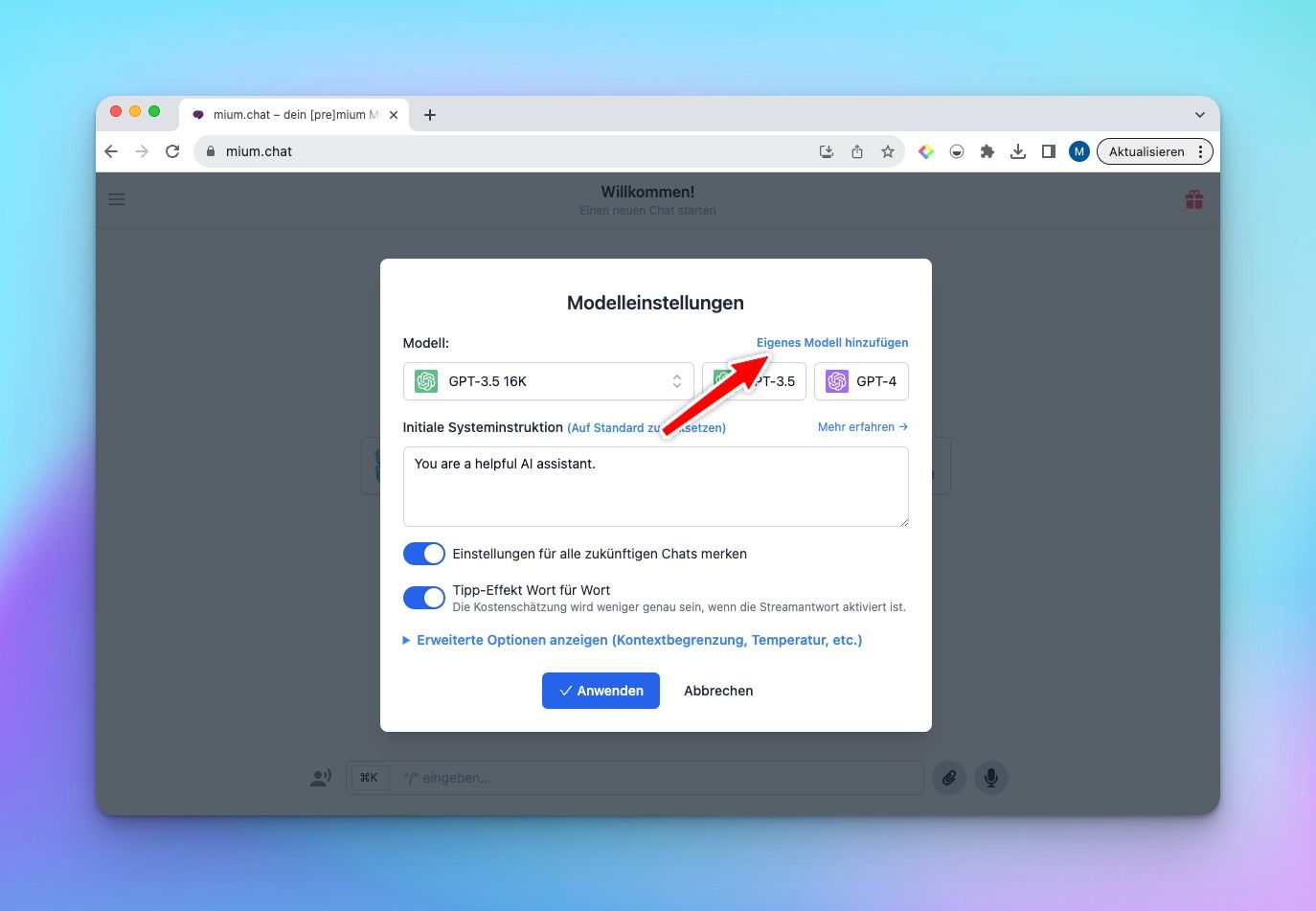

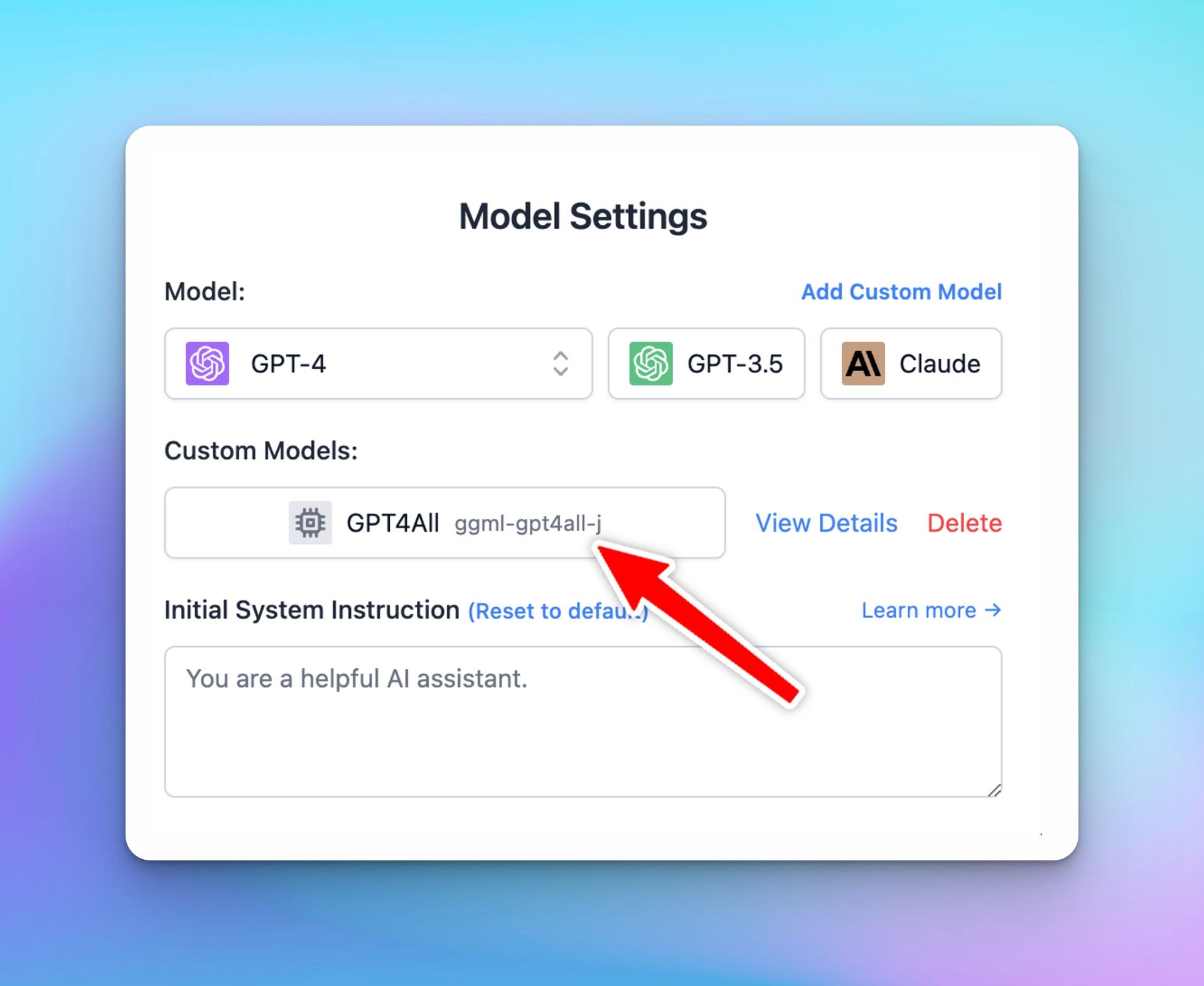

Öffne mium.chat und öffne die Schaltfläche "Modelleinstellungen" und klicke dann auf "Eigenes Modell hinzufügen".

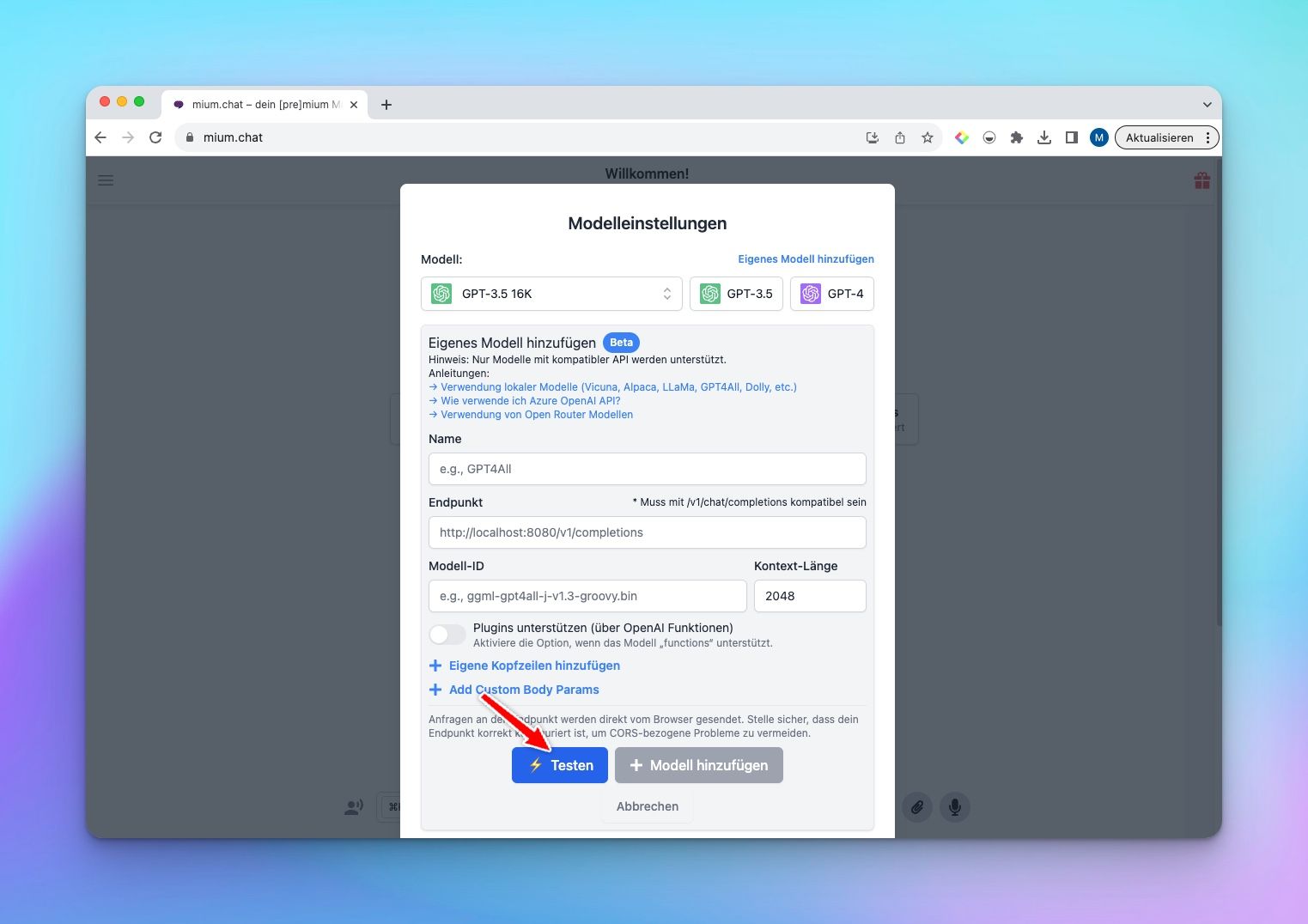

Gib alle Details ein und klicke dann auf "Testen", um zu überprüfen, ob dein benutzerdefiniertes Modell richtig funktioniert.

Bekannte Probleme bei diesem Schritt

- Problem: CORS-bezogene Probleme

Lösung: Vergewissere dich, dass deine Serverkonfiguration es zulässt, dass der Endpunkt vom Browser aus zugänglich ist. Öffne die Registerkarte Netzwerk in der Browserkonsole, um weitere Details zu sehen. - Problem: Lange Wartezeit

Lösung: Bei der ersten Anfrage kann es sehr lange dauern, bis dein Modell antwortet. Überprüfe das Terminalprotokoll des Docker-Prozesses, um zu sehen, ob etwas schief läuft. - Problem: Fehlender API-Schlüssel

Lösung: mium.chat unterstützt noch keine API-Schlüssel-Authentifizierung für benutzerdefinierte Modelle. Bitte konfiguriere dein benutzerdefiniertes Modell neu, um die Anforderung des API-Schlüssels zu entfernen.

Sprich mit dem neuen eigenen Model

Sobald das Modell getestet und erfolgreich hinzugefügt wurde, kannst du das benutzerdefinierte Modell auswählen und normal mit ihm kommunizieren.

Jetzt kannst du dein eigenes Modell mit größter Einfachheit nutzen.

Gutes Gelingen!